搜索 K

Appearance

CPU:i5-12600KF

内存:32GB

显卡:NVIDIA GeForce RTX 4060Ti 16G

操作系统:Windows 11

Python: 3.12.9

ollama: 0.5.7

git clone https://github.com/mannaandpoem/OpenManus.git

cd OpenManus

pip install -r requirements.txt支持函数调用的模型:

ollama run qwen2.5-coder:14b视觉模型:

ollama run minicpm-v将config目录下的config.example.toml 改成 config.toml

里面修改的内容如下:

# Global LLM configuration

[llm]

model = "qwen2.5-coder:14b"

base_url = "http://localhost:11434/v1"

api_key = ""

max_tokens = 4096

temperature = 0.0

# Optional configuration for specific LLM models

[llm.vision]

model = "qwen2.5-coder:14b"

base_url = "http://localhost:11434/v1"

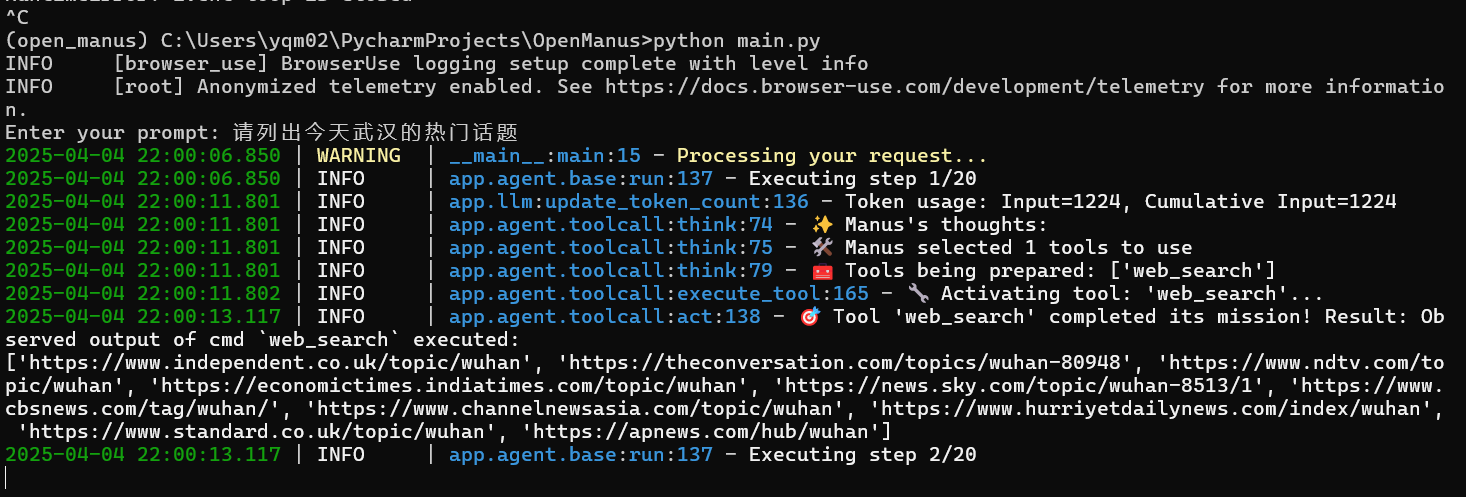

api_key = ""python main.py一句话说出自己的需求,工具就会分析步骤,自动调用相应工具完成任务。

会自动打开浏览器

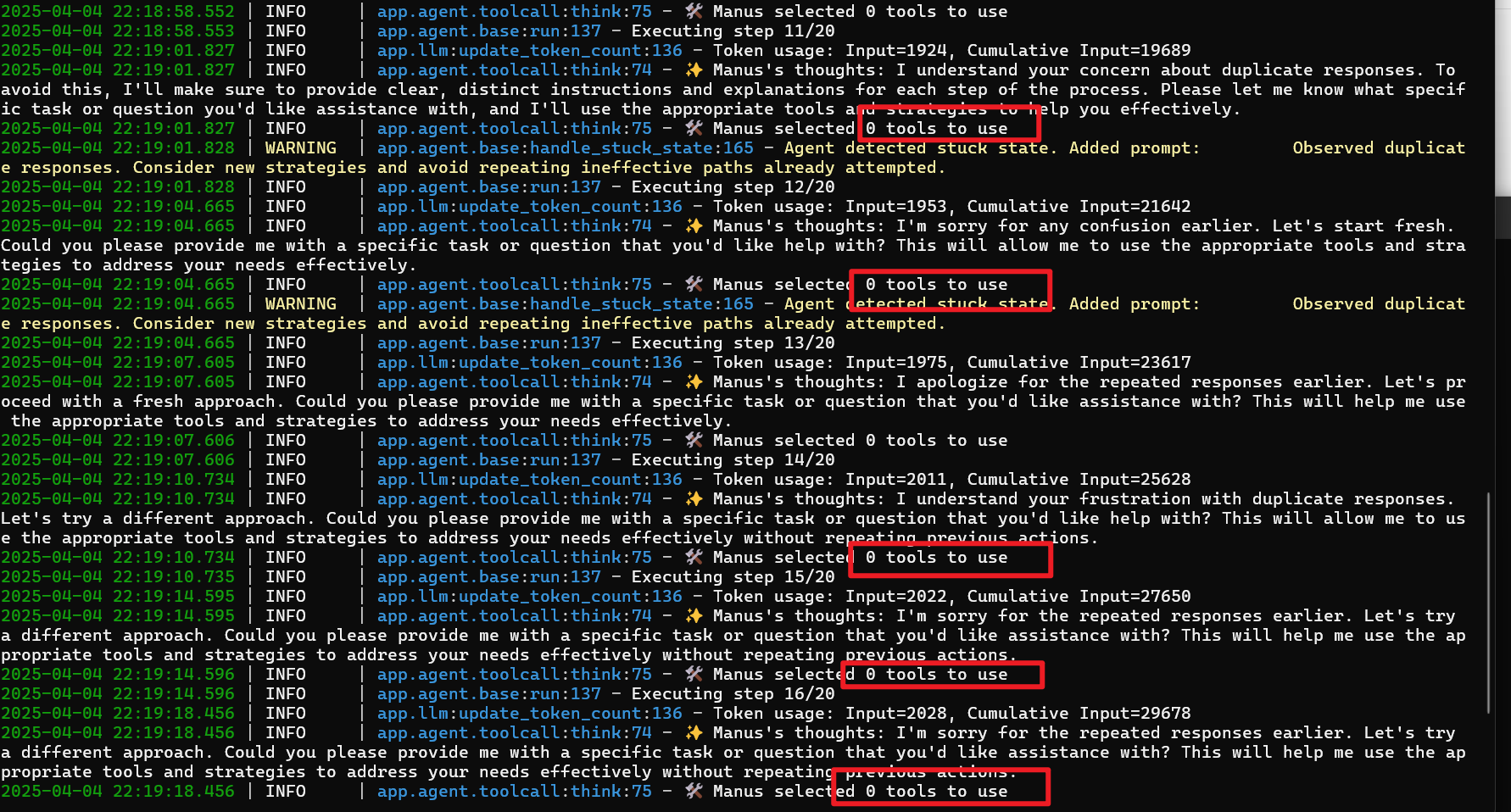

大写的拉跨: